「メタバース」という概念は「ネットワークや情報の中だけで完結する世界」「完全に非物質的なものだけで構成された世界」ではない。「現実世界」にネットワーク内の情報が重なる形で存在していても、それもまたメタバースである——こうした話は、幾度となく繰り返されてきた。

このような状態、つまり「現実世界」に「ネットワーク内の情報が重なった」状態は、一般的に「AR(Augemented Reality / 拡張現実)」と呼ばれる。Nianticのジョン・ハンケ氏に代表されるように、これを「リアルワールド・メタバース」といった言葉で語る人も少なからずいるだろう。しかし、この「メタバースとしてのAR」とでも呼ぶべき状態に辿り着くには、技術的な(そして、技術だけではない様々な)障壁が無数に立ちはだかっている。

かつて、「机の上にコップの3Dモデルを置く」だけにしても様々なハードルがあった。スマホ等のデバイスに「平面」や「机」を理解させ、その上に3Dモデルを表示して配置する。さらに「机」の位置やサイズや角度がブレたりしないようにする。このあたりはだいぶクリアされつつあるが、では机の上からいきなり部屋、あるいは街に出てみたらどうなるだろうか。デバイスは自分が「街のどこにいるのか」「見ている風景が街のどこで、どの角度やどの高さなのか」をきちんと理解して、正確に3Dモデルや画像を表示してくれるだろうか? そのためには、ネットワークのむこうから「情報」を正確に載せて提示するための技術が必要だ。

ARが今後本格的に成長していくためには「いかに現実と情報を、視覚的かつ正確に結びつけるか」という技術が要求される。今回は改めて、そのために必要なものがなんなのかを、あるいはどんな取り組みがなされているのかを、少し解説してみよう。

現実にネットの情報を重ねる「AR」に必要なもの

端末やネットワークの中にある情報を現実世界と重ね合わせるには、色々と工夫が必要になる。シンプルな方法としては、「マーカー」を使う方法や「GPS」を使う方法が考えられる。

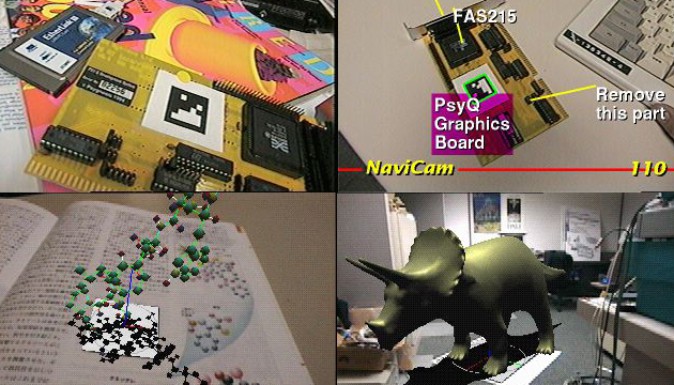

マーカーとは「CGをこの場所に配置します」と決めるための目印のようなもの。画像認識技術でマーカーを認識し、そこにCGを重ねる。二次元コードや幾何学的なマークを使うケースが多かったが、最近では画像認識の進歩に伴い、特定の企業やブランドロゴ、絵等をマーカーとして参照することも一般的になった。

(1996年当時ソニーコンピュータサイエンス研究所に所属の暦本純一氏が発明した「CyberCode」。マーカーを使ったARのひとつ。 出典:ソニーコンピュータサイエンス研究所「Matrix: A Realtime Object Identification and Registration Method for Augmented Reality」)

他にもアプリ「Snapchat」の「ARレンズ」機能は、顔の特徴を画像で認識し、そこにCGを重ねている。この種の機能はサムスンやアップル、ソニーなど、多数の企業が手がけるようになった。距離センサー(ToFやLiDAR)が搭載される機種が増えていることから、こうした使い方は非常に多く見られる。

このほか、顔ではなく「建物の特徴」を認識してARを重ねる手法もある。どちらにせよ、もはやマーカーは使っていないわけで、この種のやり方を「マーカーレスAR」という。産業向けロボットなどの正確な位置認識ではマーカーを使い、エンタメ・広告向けはマーカーレスで……というのが一般的なパターンかと思う。

そしてGPSはご存知の通り「(スマートフォンなどを使い)衛星からの信号と携帯電話基地局の情報などから、自分の位置を把握するシステム」だ。Google Map等で自分の場所がわかるのもGPSのおかげ。AR的には数十cmから数mの誤差はあるが、おおまかな位置を把握してそこにCGを出すことはできる。

GPSを使ったものの中でも非常にメタバース的なサービスとして、Niantic社の「Ingress」や「ポケモンGO」がある。スマホを持って外に出て、目的地まで歩くことでゲームが進行する「位置情報ゲーム」と呼ばれるサービスだ。これらのサービスは基本的に、GPSを通して「サービスの中にだけ存在している情報」と「現実の場所」を紐づけている。

結果として、スマホのゲーム画面の中には、同じゲームのプレイヤーたちだけが把握できて、関係を構築できるもう一つの世界(文字通りの「メタ」バースだ)が作られる。ポケモンGOで言えば、「目の前にポケモンがいる」ことは直接的には見えないが、ポケモンGOプレイヤー同士なら、「このあたりにポケモンがいる」ということはわかるようになっている。

だが、GPSの情報だけでは、やはり精度が不足している。だからこそポケモンGOにおいて多くの人が「(ポケモンのいる場所やジム、ポケストップ等とインタラクトできるように)うろうろ周囲を歩き回っている」のであり、画面を見ながら歩いていた。必ずしも「自分の場所が正確にゲーム側にも反映される」わけではないからだ。

大手各社から「VPS」が急速に立ち上がる、ではVPSとは何なのか?

続いては、そうした状況を変える技術について述べたい。2022年春になって、テック大手が一斉にとある技術に関する取り組みを公表しはじめた。「VPS(Visual Positioning System / ビジュアル・ポジショニング・システム)」と呼ばれる技術だ。5月11日にGoogleが、5月24日にはNianticが発表を行い、さらにその後、Appleも関連サービスを日本で運用を開始。テック大手がVPSを「コア技術」のひとつとして注力している印象を受ける。

では、いったいVPSとはなんなのか? それは、各社のサービスから紐解いていくのが理解への近道だろう。

Googleの「ARCore Geospatial API」

まずはGoogleのサービスから見ていこう。Googleが発表したのは「ARCore Geospatial API」という技術だ。

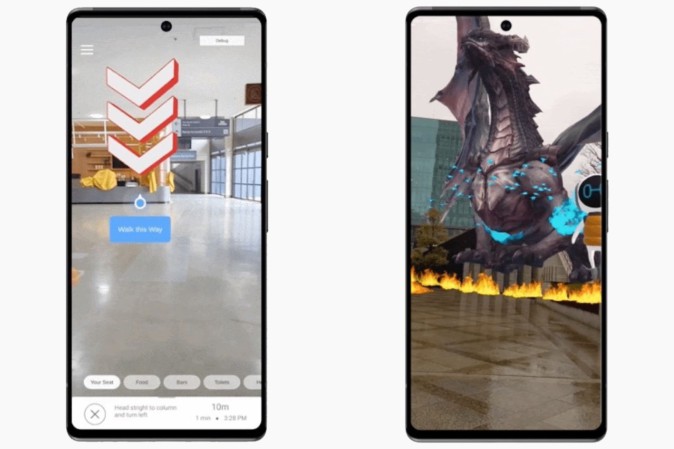

どんなことができるかは、次の2つの画像を見てもらうのがわかりやすい。これらは、Googleが5月のGoogle I/Oに合わせ、同社が公開したものだ。

(Googleが公開した「ARCore Geospatial API」デモアプリ。現実の地形や座標位置に合わせてCGが表示されているのがポイント)

どちらの画像でも共通しているのは「現実の世界にCGを重ねる」ということだ。ここで重要なのは「特定の建物やマーカーがある場所の前にCGを出しているわけではない」という点である。先ほど出てきた「マーカーレスAR」と使っている技術自体は同じ、と考えていい。

要は「自分がどこにいてどこを向いているのか」を認識した上で、仮想の地図の中にあるオブジェクトの場所に来たら、そのオブジェクトが「実際の風景の中にあるように見える」わけだ。この「仮想の空間」と「現実」を紐付ける技術こそが、ARCore Geospatial APIの正体だ。

実のところこの機能は、2022年になって公開されたものではない。元々はGoogleマップの「ライブビュー」機能に使われているものである。搭載されたのは2019年のことだ。

徒歩でスマホのナビゲーションを行う際、行き先は表示されているものの、どちらに歩き出せばいいか、迷ったことはないだろうか? GPSを使えば、自分の位置をおおまかに把握するのは難しくない。だが、GPS自体には「自分がどちらを向いているのか」を把握する機能はない。それをするのは「電子コンパス」の仕事だ。だからスマホには、GPSとセットで電子コンパスが搭載されているのだが「それだけで、本当にわかりやすくなっているか?」というとそうでもない。電子コンパスは狂いやすいし、平面の地図の上に自分の向いている方向を矢印などで示しても、それで簡単に方向がわかるわけでもない。

例えば、土地勘のない場所まで地下鉄で移動したとする。では地上へと出た時、どちらに歩き出せばいいのか。方向感覚がしっかりしていて地図が読める人なら大丈夫かもしれないが、方向音痴だと「地図は右を指しているように見えるが、本当に右に行っていいのだろうか?」と不安になるものだ(恥ずかしい話だが、筆者は無類の方向音痴だ。その手の勘違いや地図の読み違いで、スマホを手にしつつ間違った方向へと歩いていったことは何度もある)。

では、この問題はどう解決すればいいのか? 現実の風景に矢印や目的地点を出せば、間違うことはない。ただそのためには、「自分がどちらを向いているか」をより正確に知る必要がある。

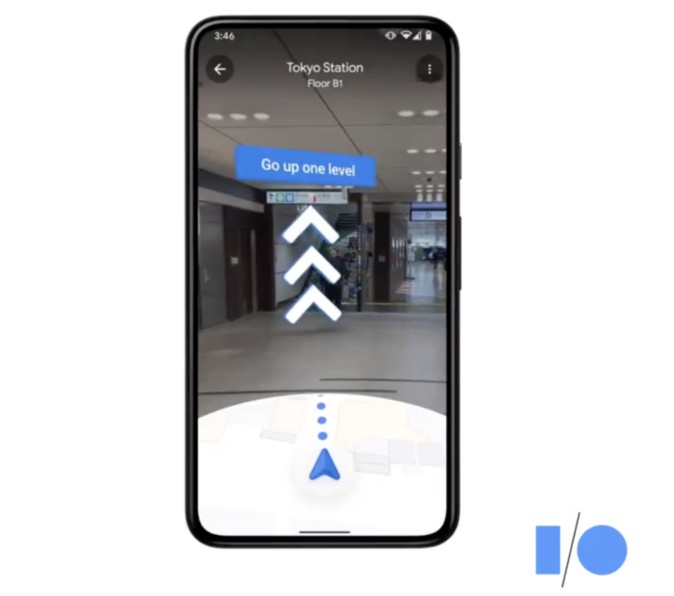

現在のGoogleマップでは、行き先検索後に「ライブビュー」を呼び出すと、カメラを使って周囲の映像をスキャンする。そしてスマホが自分の位置を認識すると、どちらに向かって歩けばいいのか、実景に矢印などを重ねて表示してくれるようになっている。現在は一部駅など、屋内でも使えるようになった。

この機能の本質はなにか。それは、カメラから得られた周囲の映像から特徴的な部分を抽出し、Googleの持つデータベースと照合することで、「今自分がどこにいて、どちらを向いているのか」を判断することにある。

自分が見ているものにCGを重ねるには、ジャイロスコープ等を使ってスマホの「向き」を認識した上で、さらにそれが風景のどこを見ているのか、という情報を利用しなければならない。そこで大量に収集した街中の特徴点データを使い、自分がいる場所・向いている場所をカメラの映像から得られる特徴点データと重ねる。そして、自分がいる正確な位置をスマホが「理解した」上で、「自分が向いている場所」に対してCGを重ねる。これでようやく、どんな場所でも自分がいる現実の風景に、ネットワークの向こうにある仮想の情報を重ねることが可能になる。

GPSが衛星を使った「グローバル・ポジショニング・システム」なら、映像から自分のいる位置を認識するから「ビジュアル・ポジショニング・システム」。というわけで、この機能は略して「VPS」と呼ばれている。

前述のように、GPSはそれだけだと数メートル以内の誤差があるし、方向もわからない。GPSとVPSを併用することで初めて、自分の向いている方向と位置を「センチメートル単位」で合わせることが可能になる(といってもGoogleのVPSの場合、まだまだ50〜60センチくらいはずれるようだが)。

元々GoogleのVPSは、Googleマップの利便性を高めるために作られたものだ。Googleは街中に「Googleカー」を走らせ、ストリートビュー用の画像データなどを収集していた。それをベースに「どこにどんな建物があるか」という3Dデータの基礎を作りつつ、さらに、Googleマップの利用者がライブビューを使うことで、最新の地点データが集まっていく。

そして今回は、Googleマップ以外の汎用アプリから使える形で機能が公開されたことも大きい。ただしそのデータは、Googleマップという巨大で利用者の多いサービスがあってこそのものだ。ARCore Geospatial APIの場合には、実際に使える形で技術情報が公開されているので、エンジニアが実際にアプリを作り、その効果を試している側面も大きい。シンプルに使うなら「Google Mapと同じことを個人でもできる」くらいの認識でいいが、ゲームからビジネスまで、その応用範囲は非常に広いだろう。

Apple: Appleも地図で「VPS」機能を活用

地図サービスとARの関係は、関連技術を開発するところなら「必ず考えている」と言っていいほど重要なものだ。Appleも2020年の年次開発者会議「WWDC 2020」では、AR用APIである「ARKit4」の機能の1つとして、「ロケーションアンカー」という機能を発表していた。

これもGoogleの「ARCore Geospatial API」と同じくVPSだ。街中の3Dデータを作成しつつ、そこから特徴的な点を取得。カメラの画像と突き合わせることで、自分がどこにいて、どこを向いているかを判断する。

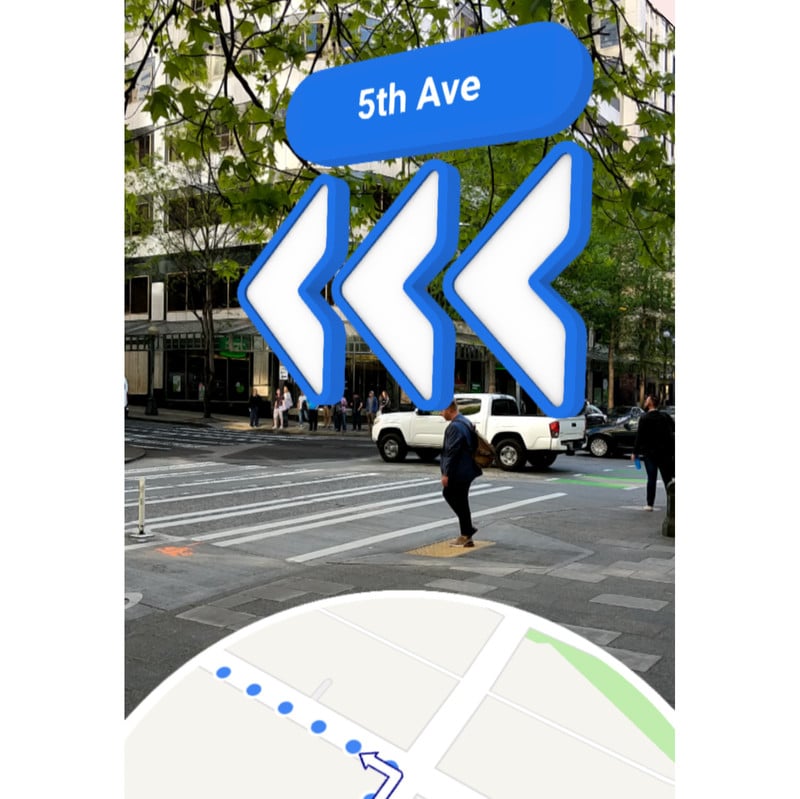

2020年当時は、サンフランシスコ市内などのごく一部の場所をカバーするに留まっていたが、現在は状況が変わってきた。2022年5月からは東京・大阪・京都・名古屋・福岡・広島・横浜などで「AR Walking」として、Appleのマップの中に、ロケーションアンカーを使った機能が組み込まれた。

実際に使ってみると、なかなか面白い。立ち止まってiPhoneを掲げて正面の建物の絵を動画でスキャンするように動かすと認識が行われる。歩いている時は普通のマップだが、曲がり角などで立ち止まってiPhoneを動かすと、AR Walkingの機能として、行き先への矢印が現れる。「立ち止まったらiPhoneを掲げて周囲をスキャン」するだけでいいので、かなり道には迷いにくくなる印象だ。

(AR Walkingを都内で使ってみた時の様子。Googleマップの「ライブビュー」に近い機能だが、動作はよりシンプル。目の前の風景をスキャンすると、向かうべき方向の矢印が空中に表示される)

Appleの場合、OS上の機能として搭載されたものを「自社のマップでも他社も使う」形なので、「マップ」アプリでも、AppleのARフレームワーク「ARKit 6」を使ったアプリでも同じ機能が使える、ということになる。

Nianticの「Lightship VPS」はちょっと違う。「移動先」を考える

Nianticは2022年5月、米サンフランシスコで開催した開発者会議「Lightship Summit」で、開発中だったARフレームワーク「Lightship」と、このフレームワークを通して使うVPS「Lightship VPS」を発表した。

Lightship VPSの場合、2022年のスタート段階では、東京・サンフランシスコ・ロンドン・ロサンゼルス・ニューヨーク・シアトルの都市のうち、3万以上の場所が、VPSが使える「スポット」として公開されている。

Nianticは他社と違い、地図を「面」で塗りつぶしているわけではない。「Ingress」や「ポケモンGO」といった、Nianticの位置情報ゲームのプレイヤーが、「地点の情報」の形で収集した風景がVPSのスポットとして利用されているためだ。これは、「移動中」よりも「移動先」のことを考える、Nianticらしいやり方と言える。

特に同社の場合、2022年初頭に買収を発表した「8th Wall」の技術を使い、「WebARでのVPS」を実現したのも興味深い。なおWebARとは、Webブラウザ経由でARを使う技術のこと。アプリのようにインストールは不要で、Webブラウザだけで体験できる。これにより、AR体験を圧倒的に手軽なものにしている(そして、ECやエンタメでの利用例も多い)。

ARグラス時代に向けては、課題も山積。一筋縄ではいかない

では、なぜここまで急に各社がVPS技術を展開してきたのか? はっきりとした理由は不明ながらも、ある種の「時代の変化」を皆が感じ取っているのかもしれない。

VPSそのものは、以前から国内・海外問わず複数の企業や組織が開発を続けてきた。それは「屋外でスマホARを使うときに有用だから」という理由があるのはもちろん、いわゆる「ARグラス」おいてもVPSが有用だということがわかっているからだ。ARグラスでCGを実景に重ねるには、「自分がどこにいるのか」「どの方向を向いているのか」を知る必要がある。そして前述のように、スマホのGPSだけでは精度や能力が不足している。ゆえに、VPSを使って、センチメートル単位での位置合わせを行う必要がある、というわけだ。

(韓国のMAXSTが開発を行っている「MAXST VPS」。 画像:MAXST)

一方で、「色々な地域をカバーすること」「広く様々な場所で使えるようにすること」が大きな課題として立ち塞がる。すると、既に地図サービスや地図を活かしたアプリを展開している大手プラットフォーマーに有利な部分があるのは否めない。しかしそうした大手であっても(Googleが多少先行しているものの)カバー領域はまだまだ都市部が中心だ。

もちろん、カバーするエリアの範囲以外にも課題は山積している。まずは「負荷」だ。画像認識は高い処理能力を必要とする技術であり、VPSを常に使いつづけると処理負荷が大きくなり、小型軽量が求められるARグラスにとっては厳しい条件だ。スマートフォンと接続するタイプでも負荷は高く、解決にはまだ時間がかかりそうだ(これについてはとても話が長くなるので、今回は割愛する)。

次に「プライバシー」の問題もある。例えば「VPSのためにカメラを搭載したARグラス」が、位置や向きを把握するためとはいえ「常にカメラをオンにして動いている」としたら、周囲の人は「常にカメラで撮影されていて、プライバシーが侵害されているのでは?」と考える可能性がある。必要な時だけVPSを使うようにした上で、さらに「VPSでカメラを使うことは、あなたの姿を撮影しているのとは違う」ということを理解してもらう必要もあるだろう。

「ARメタバース」のプライバシー問題をリサーチする「Project Aria」

そこで、Meta(当時のFacebook)が「Facebook Connect 2020」で発表し、現在も進めているリサーチプロジェクト「Project Aria」だ。「Gemini」と呼ばれるスマートグラスも試作され、実際に、Metaのサンフランシスコやシアトル、シンガポール、イギリスなどの研究関連施設の近くで使われている。

Project Ariaはリサーチプロジェクトであり、基本的にはそのままデバイスを販売することを目的としていない。デバイスもディスプレイを搭載しておらず、周囲の情報を取得するためのカメラやマイクのみを搭載している。

Geminiは「Metaの社員である」ことがわかるジャケットを着用する形で使われており、街中での視界や注目点などを記録するために使われているという。さらに映像は自動的に人の顔や自動車のナンバープレートを自動的にぼかした形で保存され、プライバシーへの対策が行われている。

(Geminiを使ってデータを収集するMeta社員。画像:Meta)

こうしたデータ収集の目的は、「ARグラスを作る上でどういう視界(=情報)を意識する必要があるか」ということを理解すると同時に、「公衆の場でカメラのついたグラスデバイスを使うことに、どのような課題があるのか」を洗い出すことだ。またProject ARIAのリサーチ結果を使い、視覚障害者に対して「声でナビ」を提供する研究も進められている。要はVPSと同じ技術で位置を把握した上で、どこを動いているかを「声」で伝えるわけだ。

カメラをセンサーとして搭載したARグラスについては、プライバシーや利用ルールを含めたコンセンサスの醸成が必須だ。現状ではこのようなデバイスが世の中に(さほど)ない以上、必然的にコンセンサスも存在しない。家やオフィスの中ならともかく、屋外で使う上での議論は必須になる。考えてみれば、Googleが2013年に「Google Glass」の提供をスタートした時には、そうした議論の必要性について考える暇もなく、発表されてから一気に懸念が盛り上がった(実際にはハードウェアの特性的に、そこまでプライバシーの問題が起きるような使い方をするのは難しかったわけだが……)。

MetaがProject Ariaのようなリサーチを行う理由は、当然ながら「屋外で使う本格的なARデバイスの開発」を視野に入れているからだろう。まだスマホをかざしているうちはそんなに深刻な問題は出ないはずだ(スマホで写真を撮影するのと変わらない。もちろん撮影を嫌がる人や状況もあるのは間違いないが)。一方でARグラスの時代を考えると、こうしたリサーチから得られた知見を活かしつつ、製品とサービスの構築を進めていく必要があるだろう。このような、「プライバシー」と「コンピュータやデバイスに世界の状態を理解してもらう」ことについての議論はこれからより深まっていくように思われる。

(執筆:西田宗千佳、編集:水原由紀)

からの記事と詳細 ( 「メタバースとしてのAR」にはなにが必要なのか。テック大手各社が仕掛ける「VPS」技術から読み解く - Mogura VR )

https://ift.tt/EaVLw0Y

No comments:

Post a Comment